این روزها بازار طراحی سایت و خدمات سئو به شدت داغ است و صاحبین کسب و کارهای مختلف به این نتیجه رسیدند که میتوانند با داشتن فروشگاه مجازی، درآمد خود را افزایش دهند و به شرایط بهتری دست پیدا کنند.

سایتها دارای بخشها و صفحات مختلفی هستند که هر کدام از آنها مخصوص شرایط خاصی بوده و مخاطب خاص خود را دارند. همانطور که میدانید با تعیین و ایجاد تقویم محتوایی مناسب با مخاطبان سایت خود، بازدید سایت روز به روز افزایش خواهد داشت. تعدادی از صفحات نباید در دسترس کاربران قرار بگیرند. در این صورت امنیت سایت به خطر خواهد افتاد. برای جلوگیری از چنین شرایطی، از فایلی با نام robots.txt استفاده میشود. در این مطلب تصمیم داریم تا شما را با این فایل آشنا کنیم و کاربردهای آن را بیان نماییم. با ما همراه باشید.

فایل robots.txt چیست؟

یکی از مهمترین فایلهایی که در سئو وجود دارد فایل robots.txt است که در همان مراحل ابتدایی شروع فرآیند بهینه سازی سایت آن را ساخته و بارگذاری میکنند. اگر شما از خدمات طراحی سایت در مشهد استفاده کرده باشید میدانید که سایتها دارای صفحاتی امنیتی هستند که نباید هیچ کسی به آنها دسترسی داشته باشد. علاوه بر این صفحات، بخشهای دیگری نیز هستند که با توجه به نکات سئو باید آنها را ببندیم.

این دقیقا کاری است که robots.txt انجام میدهد. شما برای کنترل رباتهای گوگل به robots.txt نیاز دارید. گوگل داری رباتهای مختلفی است که هر کدام از آنها دارای کاربردی خاص هستند و مهمترین نوع آنها رباتی است که برای ایندکس صفحات سایتها، آنها را بررسی کرده و در منابع گوگل ذخیره میکند.

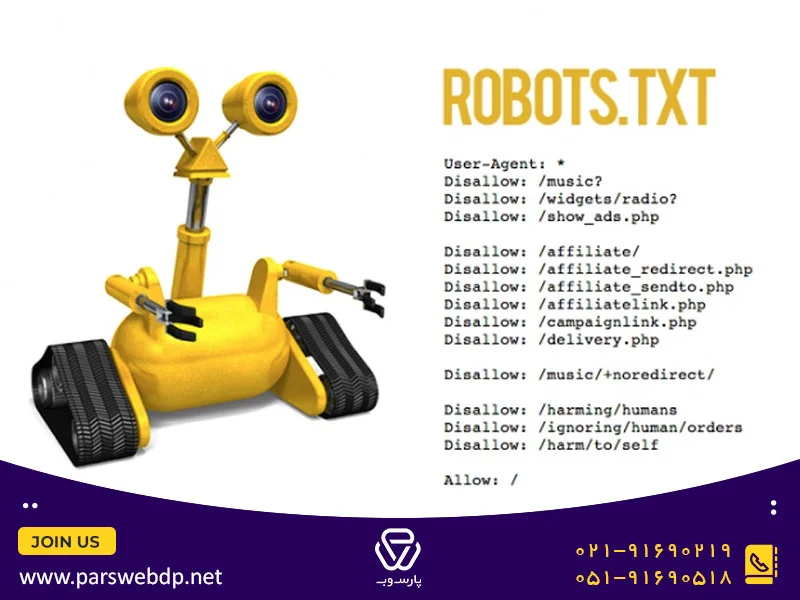

فایل robots.txt یک نوع مجوز است که میتواند این رباتها را کنترل کرده و از ورود آنها به صفحات ممنوع جلوگیری میکند. این یک فایل متنی است که شما باید آن را در مسیر اصلی فضای سایت خود یا روت دایرکتوری بارگذاری کنید.

شما با استفاده از دستوراتی ساده و خاص میتوانید به خزندههای گوگل اعلام کنید که باید وارد کدام صفحات شده و از کدام موارد دوری کنند. اولین چیزی که خزندههای گوگل با آن برخورد میکنند همین فایل است و با توجه به آن متوجه میشوند باید کدام مسیر را در پیش گرفته و به راه خود ادامه دهند. آدرس فایل robots.txt به صورت زیر است:

www.YourDomain.com/robots.txt

البته باید به این نکته نیز اشاره کنیم اگر صفحه سایت شما خیلی مهم بوده و به هیچ عنوان نباید ایندکس شود، بهتر است از تگ noindex نیز در صفحه مورد نظر استفاده کنید چرا که در شرایطی ممکن است رباتها از robots.txt پیروی نکنند. برای مثال اگر سایت دیگری دقیقا به همین آدرسی که مسدود کردید لینک بدهد، خزندهها وارد صفحه مورد نظر خواهند شد. پس درجه اهمیت صفحات سایت را باید در نظر بگیرید.

اهمیت فایل robots.txt

شاید هنوز هم اهمیت این فایل را متوجه نشده باشید. برای مثال فرض کنید یکی از صفحات امنیتی سایت شما، برای مثال صفحه ورود به بخش ادمین سایت، توسط گوگل ایندکس شده است. در این شرایط هر مورد امنیتی که برای این صفحه در نظر گرفتید از بین رفته و اگر هکری بخواهد میتواند وارد آن شده و در سایت شما خراب کاری کند.

از طرفی شما بودجه خزش مشخصی دارید که باید به صورت بهینه از آن استفاده کنید. اگر صفحات بیخود و بدون کاربرد را در فایل robots.txt نبندید، بودجه خزش شما برای کرال آنها از بین رفته و صفحات مهم جا میمانند. این سرعت ایندکس سایت را کم خواهد کرد.

باید به این دقت کنید که کدهای robots.txt را به درستی وارد کرده و همچنین آن را در بخش مناسب و درست بارگذاری کنید. در غیر این صورت این فایل عمل نکرده و هیچ چیزی مانع خزندههای گوگل نخواهد شد.

در آخر نیز باید به این موضوع اشاره کنیم که اگر پروژه سایت خود را به یکی از آژانسهای دیجیتال مارکتینگ در مشهد سپردید، دیگر نیازی نیست نگران این فایل باشید چرا که متخصصین این شرکت قطعا به خوبی فایل robots.txt را بهینه سازی مینمایند.

چه مواردی باید در فایل robots.txt آورده شوند؟

اینکه چه مواردی را در فایل robots.txt آورده و کدام گزینهها را ببندید، کاملا به پروژه شما بستگی دارد. ولی برخی از قسمتها در تمامی سایتها یکسان بوده و باید در تمامی پروژهها بسته شوند.

وردپرس یک سیستم مدیریت محتوایی است که با ایجاد کدهای بک اند پیش فرض میتواند کار طراحی سایت را راحت کند. اکثر سایتهایی که این روزها طراحی شده و در اینترنت مشاهده میشوند، با وردپرس طراحی شدهاند. در این نوع سایتها صفحاتی مثلwp-admin ، readme.htm و plugins که مربوط به پلاگینها یا افزونههای سایت(آموزش نصب افزونه در وردپرس را میتوانید در این مقاله از پارس وب مطالعه کنید)میباشد، وجود دارند که باید بسته شوند چرا که اطلاعات بنیادی سایت در آنها قرار داشته و افراد سودجو یا هکرها میتوانند از آنها سو استفاده نمایند.

در نظر داشته باشید که سرقت در فضای اینترنت به معنی سرقت اطلاعات شما و اطلاعات کاربران شما میباشد. اگر یک هکر بتواند وارد سایت شما شود، عملا برند مجازی شما از بین خواهد رفت. درست است که در این مطلب در رابطه با robots.txt و کاربردهای آن صحبت کردیم ولی باید به این نیز اشاره کنیم که راههای بسیاری برای آسیب زدن به فروشگاه مجازی شما وجود دارد و به همین دلیل باید به هر روشی، امنیت سایت خود را افزایش دهید.

سوالات متداول درباره فایل Robots

robots.txt یک فایل متنی است که توسط کارشناس سئو و به منظور تعیین سطح دسترسی ربات های گوگل به صفحات وبسایت ایجاد می شود.

ویرایش فایل robots.txt هم با استفاده از افزونه رنک مث و هم از طریق هاست، امکان پذیر می باشد.

برای دسترسی به فایل robots.txt به آدرس زیر مراجعه کنید:

پنل هاست -> file manager-> public_html

علاوه بر آن می توانید از طریق افزودن عبارت robots.txt/ در انتهای URL سایت خود به فایل robots دسترسی پیدا کنید.

یک فایل متنی (txt) با فرمت UTF-8 ایجاد کرده و دستورات مورد نیاز را در آن وارد و ذخیره کنید. در نهایت فایل را در هاست، آپلود کنید.